断点。

Why

What

常见RF指标的内在和意义

常见RF指标的内在和意义(一)

温故而知新

这篇文章的初衷是源自我给工厂工程师写的一份“操作指南”,按理说写这些东西对于工作了十来年的人来说应该是手到擒来的,但是真正写的时候就发现原本计划提纲挈领的东西写成了冗长无比的八股文。

写完之后回头读一读,发现其实问题只有一个:

基础概念!

基础概念!

基础概念!

重要的事情说三遍。

当你写完“EVM可能随着Front-End的IL增大而恶化”的时候,如果阅读者是一个基础概念知识都不好的工程师(工厂里的工程师很多都是如此),人家第一反应是“EVM是什么”,继而是“EVM是为什么会跟IL有关系”,然后还可能是“EVM还跟什么指标有关系”——这就没完没了了。

所以我这里打算“扯到哪算哪”,把一些常见的概念列举出来,抛砖引玉,然后看看效果如何。

Rx Sensitivity(接收灵敏度)

接收灵敏度,这应该是最基本的概念之一,表征的是接收机能够在不超过一定误码率的情况下识别的最低信号强度。这里说误码率,是沿用CS(电路交换)时代的定义作一个通称,在多数情况下,BER (bit error rate)或者PER (packet error rate)会用来考察灵敏度,在LTE时代干脆用吞吐量Throughput来定义——因为LTE干脆没有电路交换的语音信道,但是这也是一个实实在在的进化,因为第一次我们不再使用诸如12.2kbps RMC(参考测量信道,实际代表的是速率12.2kbps的语音编码)这样的“标准化替代品”来衡量灵敏度,而是以用户可以实实在在感受到的吞吐量来定义之。

SNR(信噪比)

讲灵敏度的时候我们常常联系到SNR(信噪比,我们一般是讲接收机的解调信噪比),我们把解调信噪比定义为不超过一定误码率的情况下解调器能够解调的信噪比门限(面试的时候经常会有人给你出题,给一串NF、Gain,再告诉你解调门限要你推灵敏度)。那么S和N分别何来?

S即信号Signal,或者称为有用信号;N即噪声Noise,泛指一切不带有有用信息的信号。有用信号一般是通信系统发射机发射出来,噪声的来源则是非常广泛的,最典型的就是那个著名的-174dBm/Hz——自然噪声底,要记住它是一个与通信系统类型无关的量,从某种意义上讲是从热力学推算出来的(所以它跟温度有关);另外要注意的是它实际上是个噪声功率密度(所以有dBm/Hz这个量纲),我们接收多大带宽的信号,就会接受多大带宽的噪声——所以最终的噪声功率是用噪声功率密度对带宽积分得来。

Tx Power(发射功率)

发射功率的重要性,在于发射机的信号需要经过空间的衰落之后才能到达接收机,那么越高的发射功率意味着越远的通信距离。

那么我们的发射信号要不要讲究SNR?譬如说,我们的发射信号SNR很差,那么到达接收机的信号SNR是不是也很差?

这个牵涉到刚才讲过的概念,自然噪声底。我们假设空间的衰落对信号和噪声都是效果相同的(实际上不是,信号能够通编码抵御衰落而噪声不行)而且是如同衰减器一般作用的,那么我们假设空间衰落-200dB,发射信号带宽1Hz,功率50dBm,信噪比50dB,接收机收到信号的SNR是多少?

接收机收到信号的功率是50-200=-150Bm(带宽1Hz),而发射机的噪声50-50=0dBm通过空间衰落,到达接收机的功率是0-200=-200dBm(带宽1Hz)?这时候这部分噪声早已被“淹没”在-174dBm/Hz的自然噪声底之下了,此时我们计算接收机入口的噪声,只需要考虑-174dBm/Hz的“基本成分”即可。

这在通信系统的绝大部分情况下是适用的。

ACLR/ACPR

我们把这些项目放在一起,是因为它们表征的实际上是“发射机噪声”的一部分,只是这些噪声不是在发射信道之内,而是发射机泄漏到临近信道中去的部分,可以统称为“邻道泄漏”。

其中ACLR和ACPR(其实是一个东西,不过一个是在终端测试中的叫法,一个是在基站测试中的叫法罢了),都是以“Adjacent Channel”命名,顾名思义,都是描述本机对其他设备的干扰。而且它们有个共同点,对干扰信号的功率计算也是以一个信道带宽为计。这种计量方法表明,这一指标的设计目的,是考量发射机泄漏的信号,对相同或相似制式的设备接收机的干扰——干扰信号以同频同带宽的模式落到接收机带内,形成对接收机接收信号的同频干扰。

在LTE中,ACLR的测试有两种设置,EUTRA和UTRA,前者是描述LTE系统对LTE系统的干扰,后者是考虑LTE系统对UMTS系统的干扰。所以我们可以看到EUTRA ACLR的测量带宽是LTE RB的占用带宽,UTRA ACLR的测量带宽是UMTS信号的占用带宽(FDD系统3.84MHz,TDD系统1.28MHz)。换句话说,ACLR/ACPR描述的是一种“对等的”干扰:发射信号的泄漏对同样或者类似的通信系统发生的干扰。

这一定义是有非常重要的实际意义的。实际网络中同小区邻小区还有附近小区经常会有信号泄漏过来,所以网规网优的过程实际上就是容量最大化和干扰最小化的过程,而系统本身的邻道泄漏对于邻近小区就是典型的干扰信号;从系统的另一个方向来看,拥挤人群中用户的手机也可能成为互相的干扰源。

同样的,在通信系统的演化中,从来是以“平滑过渡”为目标,即在现有网络上升级改造进入下一代网络。那么两代甚至三代系统共存就需要考虑不同系统之间的干扰,LTE引入UTRA即是考虑了LTE在与UMTS共存的情形下对前代系统的射频干扰。

Modulation Spectrum/Switching Spectrum

而退回到GSM系统,Modulation Spectrum(调制谱)和Switching Spectrum(切换谱,也有称为开关谱的,对舶来品不同翻译的缘故)也是扮演了邻道泄漏相似的角色。不同的是它们的测量带宽并不是GSM信号的占用带宽。从定义上看,可以认为调制谱是衡量同步系统之间的干扰,而切换谱是衡量非同步系统之间的干扰(事实上如果不对信号做gating,切换谱一定是会把调制谱淹没掉的)。

这就牵涉到另一个概念:GSM系统中,各小区之间是不同步的,虽然它用的是TDMA;而相比之下,TD-SCDMA和之后的TD-LTE,小区之间是同步的(那个飞碟形状或者球头的GPS天线永远是TDD系统摆脱不了的桎梏)。

因为小区间不同步,所以A小区上升沿/下降沿的功率泄漏可能落到B小区的payload部分,所以我们用切换谱来衡量此状态下发射机对邻信道的干扰;而在整个577us的GSM timeslot里,上升沿/下降沿的占比毕竟很少,多数时候两个相邻小区的payload部分会在时间上交叠,评估这种情况下发射机对邻信道的干扰就可以参考调制谱。

SEM (Spectrum Emission Mask)

讲SEM的时候,首先要注意它是一个“带内指标”,与spurious emission区分开来,后者在广义上是包含了SEM的,但是着重看的其实是发射机工作频段之外的频谱泄漏,其引入也更多的是从EMC(电磁兼容)的角度。

SEM是提供一个“频谱模版”,然后在测量发射机带内频谱泄漏的时候,看有没有超出模版限值的点。可以说它与ACLR有关系,但是又不相同:ACLR是考虑泄漏到邻近信道中的平均功率,所以它以信道带宽为测量带宽,它体现的是发射机在邻近信道内的“噪声底”;SEM反映的是以较小的测量带宽(往往100kHz到1MHz)捕捉在邻近频段内的超标点,体现的是“以噪声底为基础的杂散发射”。

如果用频谱仪扫描SEM,可以看到邻信道上的杂散点会普遍的高出ACLR均值,所以如果ACLR指标本身没有余量,SEM就很容易超标。反之SEM超标并不一定意味着ACLR不良,有一种常见的现象就是有LO的杂散或者某个时钟与LO调制分量(往往带宽很窄,类似点频)串入发射机链路,这时候即便ACLR很好,SEM也可能超标。

EVM(误差矢量)

首先,EVM是一个矢量值,也就是说它有幅度和角度,它衡量的是“实际信号与理想信号的误差”,这个量度可以有效的表达发射信号的“质量”——实际信号的点距离理想信号越远,误差就越大,EVM的模值就越大。

发射信号的EVM与SNR

EVM是如何与SNR扯上关系的呢?这里摘录一段度娘上的文献:

图一

这是发射机天线口处的信噪比,反映的是发射信号的“固有信噪比”。

在(一)中我们曾经解释过为什么发射信号的信噪比不是那么重要,原因有二:第一是发射信号的SNR往往远远高于接收机解调所需要的SNR;第二是我们计算接收灵敏度时参考的是接收机最恶劣的情况,即在经过大幅度空间衰落之后,发射机噪声早已淹没在自然噪声底之下,而有用信号也被衰减到接收机的解调门限附近。

但是发射机的“固有信噪比”在某些情况下是需要被考虑的,譬如近距离无线通信,典型的如802.11系列。

802.11系列演进到802.11ac的时候,已经引入了256QAM的调制,对于接收机而言,即便不考虑空间衰落,光是解调这样高阶的正交调制信号就已经需要很高的信噪比,EVM越差,SNR就越差,解调难度就越高。

作为发射机性能指标的EVM

这里我想拓开来讲一下EVM在衡量发射机性能上的作用。

做802.11系统的工程师,往往用EVM来衡量Tx线性度;而做3GPP系统的工程师,则喜欢用ACLR/ACPR/Spectrum来衡量Tx线性性能。

从起源上讲,3GPP是蜂窝通信的演进道路,从一开始就不得不关注邻信道、隔信道(adjacent channel, alternative channel)的干扰(北邮通信工程毕业的学生应该都学过怎么按照六边形小区推算最近的邻频小区)。换句话说,干扰是影响蜂窝通信速率的第一大障碍,所以3GPP在演进的过程中,总是以“干扰最小化”为目标的:GSM时代的跳频,UMTS时代的扩频,LTE时代RB概念的引入,都是如此。

而802.11系统是固定无线接入的演进,它是秉承TCP/IP协议精神而来,以“尽最大能力的服务”为目标,802.11中经常会有时分或者跳频的手段来实现多用户共存,而布网则比较灵活(毕竟以局域网为主),信道宽度也灵活可变。总的来说它对干扰并不敏感(或者说容忍度比较高)。

通俗的讲,就是蜂窝通信的起源是打电话,打不通电话用户会去电信局砸场子;802.11的起源是局域网,网络不好大概率是先耐着性子等等(其实这时候设备是在作纠错和重传)。

这就决定了3GPP系列必然以ACLR/ACPR一类“频谱再生”性能为指标,而802.11系列则可以以牺牲速率来适应网络环境。

具体说来,“以牺牲速率来适应网络环境”,就是指的802.11系列中以不同的调制阶数来应对传播条件:当接收机发现信号差,就立即通知对面的发射机降低调制阶数,反之亦然。前面提到过,802.11系统中SNR与EVM相关很大,很大程度上EVM降低可以提高SNR。这样我们就有两种途径改善接收性能:一是降低调制阶数,从而降低解调门限;二是降低发射机EVM,使得信号SNR提高。

因为EVM与接收机解调效果密切相关,所以802.11系统中以EVM来衡量发射机性能(类似的,3GPP定义的蜂窝系统中,ACPR/ACLR是主要影响网络性能的指标);又因为发射机对EVM的恶化主要因为非线性引起(譬如PA的AM-AM失真),所以EVM通常作为衡量发射机线性性能的标志。

EVM与ACPR/ACLR的关系

很难定义EVM与ACPR/ACLR的定量关系,从放大器的非线性来看,EVM与ACPR/ACLR应该是正相关的:放大器的AM-AM、AM-PM失真会扩大EVM,同时也是ACPR/ACLR的主要来源。

但是EVM与ACPR/ACLR并不总是正相关,我们这里可以找到一个很典型的例子:数字中频中常用的Clipping,即削峰(嗯,不是那位辽国南院大王、前丐帮帮主)。Clipping是削减发射信号的峰均比(PAR),峰值功率降低有助于降低通过PA之后的ACPR/ACLR;但是Clipping同时会损害EVM,因为无论是限幅(加窗)还是用滤波器方法,都会对信号波形产生损伤,因而增大EVM。

PAR的源流

PAR(信号峰均比)通常用CCDF这样一个统计函数来表示,其曲线表示的是信号的功率(幅度)值和其对应的出现概率。譬如某个信号的平均功率是10dBm,它出现超过15dBm功率的统计概率是0.01%,我们可以认为它的PAR是5dB。

射频君注:峰均比,或称峰值因数(crest factor),简称PAR(peak-to-average ratio),或叫峰均功率比(简称PARR,peak-to-average power ratio)。

先说定义:峰均比是一种对波形的测量参数,等于波形的振幅除以有效值(RMS)所得到的一个比值。

对这个定义还有一种理解:峰值的功率和平均功率之比。

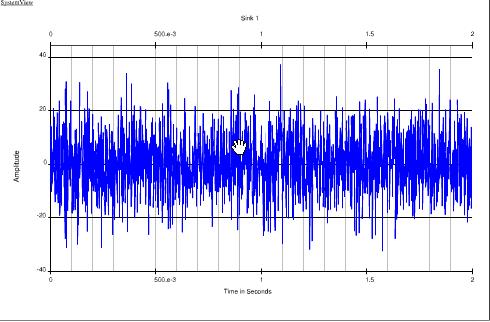

这里先了解峰值功率:很多信号从时域观测并不是恒定的包络,而是如下面图所示:

峰值功率既是只以某种概率出现的肩峰的瞬时功率。通常概率取为0.01%。

平均功率是系统输出的实际功率。

在某个概率下峰值功率跟平均功率的比就称为某个概率下的峰均比,比如PAR=9.1@0.1%,各种概率的峰均比就形成了CCDF曲线(互补累积分布函数)。

在概率为0.01%处的PAR,一般称为CREST因子,这也是来自于CDMA系统的定义。

PAR是现代通信系统中发射机频谱再生(诸如ACLP/ACPR/Modulation Spectrum)的重要影响因素。峰值功率会将放大器推入非线性区从而产生失真,往往峰值功率越高、非线性越强。

在GSM时代,因为GMSK调制的衡包络特性,所以PAR=0,我们在设计GSM功放的时候经常把它推到P1dB,以得到最大限度的效率。引入EDGE之后,8PSK调制不再是衡包络,因此我们往往将功放的平均输出功率推到P1dB以下3dB左右,因为8PSK信号的PAR是3.21dB。

UMTS时代,无论WCDMA还是CDMA,峰均比都比EDGE大得多。原因是码分多址系统中信号的相关性:当多个码道的信号在时域上叠加时,可能出现相位相同的情况,此时功率就会呈现峰值。

LTE的峰均比则是源自RB的突发性。OFDM调制是基于将多用户/多业务数据在时域上和频域上都分块的原理,这样就可能在某一“时间块”上出现大功率。LTE上行发射用SC-FDMA,先用DFT将时域信号扩展到频域上,等于“平滑”掉了时域上的突发性,从而降低了PAR。

干扰指标汇总

这里的“干扰指标”,指的是出了接收机静态灵敏度之外,各种施加干扰下的灵敏度测试。实际上研究这些测试项的由来是很有意思的。

我们常见的干扰指标,包括Blocking,Desense,Channel Selectivity等。

Blocking(阻塞)

Blocking实际上是一种非常古老的RF指标,早在雷达发明之初就有。其原理是以大信号灌入接收机(通常最遭殃的是第一级LNA),使得放大器进入非线性区甚至饱和。此时一方面放大器的增益骤然变小,另一方面产生极强非线性,因而对有用信号的放大功能就无法正常工作了。

另一种可能的Blocking其实是通过接收机的AGC来完成的:大信号进入接收机链路,接收机AGC因此产生动作降低增益以确保动态范围;但是同时进入接收机的有用信号电平很低,此时增益不足,进入到解调器的有用信号幅度不够。

Blocking指标分为带内和带外,主要是因为射频前端一般会有频带滤波器,对于带外blocking会有抑制作用。但是无论带内还是带外,Blocking信号一般都是点频,不带调制。事实上完全不带调制的点频信号在现实世界里并不多见,工程上只是把它简化成点频,用以(近似)替代各种窄带干扰信号。

对于解决Blocking,主要是RF出力,说白了就是把接收机IIP3提高,动态范围扩大。对于带外Blocking,滤波器的抑制度也是很重要的。

AM Suppression

AM Suppression是GSM系统特有的指标,从描述上看,干扰信号是与GSM信号相似的TDMA信号,与有用信号同步且有固定delay。

这种场景是模拟GSM系统中邻近小区的信号,从干扰信号的频偏要求大于6MHz(GSM带宽200kHz)来看,这是很典型的邻近小区信号配置。所以我们可以认为AM Suppression是一个反映GSM系统实际工作中接收机对邻小区的干扰容忍度。

Adjacent (Alternative) Channel Suppression (Selectivity)

这里我们统称为“邻信道选择性”。在蜂窝系统中,我们组网除了要考虑同频小区,还要考虑邻频小区,其原因可以在我们之前讨论过的发射机指标ACLR/ACPR/Modulation Spectrum中可以找到:因为发射机的频谱再生会有很强的信号落到相邻频率中(一般来说频偏越远电平越低,所以邻信道一般是受影响最大的),而且这种频谱再生事实上是与发射信号有相关性的,即同制式的接收机很可能把这部分再生频谱误认为是有用信号而进行解调,所谓鹊巢鸠占。

举个例子:如果两个相邻小区A和B恰好是邻频小区(一般会避免这样的组网方式,这里只是讨论一个极限场景),当一台注册到A小区的终端游走到两个校区交界处,但是两个小区的信号强度还没有到切换门限,因此终端依然保持A小区连接;B小区基站发射机的ACPR较高,因此终端的接收频带内有较高的B小区ACPR分量,与A小区的有用信号在频率上重叠;因为此时终端距离A小区基站较远,因此接收到的A小区有用信号强度也很低,此时B小区ACPR分量进入到终端接收机时就可以对原有用信号造成同频干扰。

如果我们注意看邻道选择性的频偏定义,会发现有Adjacent和Alternative的区别,对应ACLR/ACPR的第一邻道、第二邻道,可见通信协议中“发射机频谱泄漏(再生)”与“接收机邻道选择性”实际上是成对定义的。

Co-Channel Suppression (Selectivity)

这种描述的是绝对的同频干扰,一般是指两个同频小区之间的干扰模式。

按照之前我们描述的组网原则,两个同频小区的距离应该尽量远,但是即便再远,也会有信号彼此泄漏,只是强度高低的区别。对于终端而言,两个校区的信号都可以认为是“正确的有用信号”(当然协议层上有一组接入规范来防范这种误接入),衡量终端的接收机能否避免“西风压倒东风”,就看它的同频选择性。

点评:Blocking是“大信号干扰小信号”,RF尚有周旋余地;而以上的AM Suppression, Adjacent (Co/Alternative) Channel Suppression (Selectivity)这些指标,是“小信号干扰大信号”,纯RF的工作意义不大,还是靠物理层算法为主。

Single-tone Desense

Single-tone Desense是CDMA系统独有的指标,它有个特点:作为干扰信号的single-tone是带内信号,而且距离有用信号很近。这样就有可能产生两种信号落到接收频域内:第一种是由于LO的近端相噪,LO与有用信号混频形成的基带信号、和LO相噪与干扰信号混频形成的信号,都会落到接收机基带滤波器的范围之内,前者是有用的信号而后者是干扰;第二种是由于接收机系统中的非线性,有用信号(有一定带宽,譬如1.2288MHz的CDMA信号)可能与干扰信号在非线性器件上产生交调,而交调产物有可能同样落在接收频域之内成为干扰。

Single-tone desense的起源是北美在发起CDMA系统时,与原有的模拟通信系统AMPS采用了同一频段,两张网长期共存,作为后来者的CDMA系统必须考虑AMPS系统对自身的干扰。

到这里我想起当年被称为“通则不动,动则不通”的小灵通,因为长期占用1900~1920MHz频率,所以天朝TD-SCDMA/TD-LTE B39的实施一直是在B39的低段1880~1900MHz,直到小灵通退网为止。

再论Blocking

在写这篇文章的过程中,我跟以前的老同事一起讨论了一下Blocking的物理含义。

教科书上对Blocking的解释比较简单:大信号进入接收机放大器使得放大器进入非线性区,实际增益变小(对有用信号的)。

但是这样很难解释两种场景:

场景一:前级LNA线性增益18dB,当大信号灌入使其达到P1dB的时候,增益是17dB;如果没有引入其他影响(默认LNA的NF等都没有发生变化),那么对整个系统的噪声系数影响其实非常有限,无非是后级NF在计入到总NF时分母变小了一点,对整个系统的灵敏度影响不大。

场景二:前级LNA的IIP3很高因此没有受影响,受影响的是第二级gain block(干扰信号使其达到P1dB附近),在这种情况下整个系统NF的影响就更小了。

我在这里抛砖引玉,提出一个观点:Blocking的影响可能分两部分,一部分是教科书上所讲的Gain受到压缩,另一部分实际上是放大器进入非线性区之后,有用信号在这个区域里发生了失真。这种失真可能包括两部分,一部分是纯粹的放大器非线性造成有用信号的频谱再生(谐波分量),另一部分是大信号调制小信号的Cross Modulation(参考阅读:http://www.radio-electronics.com/info/rf-technology-design/receiver-overload/crossmodulation.php)。

由此我们还提出另一个设想:如果我们要简化Blocking测试(3GPP要求是扫频,非常费时间),也许可以选取某些频点,这些频点出现Blocking信号时对有用信号的失真影响最大。

从直观上看,这些频点可能有:f0/N和f0*N(f0是有用信号频率,N是自然数)。前者是因为大信号在非线性区自身产生的N次谐波分量正好叠加在有用信号频率f0上形成直接干扰,后者是叠加在有用信号f0的N次谐波上进而影响到输出信号f0的时域波形——解释一下:根据帕塞瓦尔定律,时域信号的波形实际上是频域基频信号与各次谐波的总和,当频域上N次谐波的功率发生变化时,时域上对应的变化就是时域信号的包络变化(发生了失真)。

动态范围,温度补偿与功率控制

动态范围,温度补偿和温度补偿很多情况下是“看不到”的指标,只有在进行某些极限测试的时候才会表现出它们的影响,但是本身它们却体现着RF设计中最精巧的部分。

“重剑无锋,大巧不工。”

——独孤求败。

发射机动态范围

发射机动态范围表征的是发射机“不损害其他发射指标前提下”的最大发射功率和最小发射功率。

“不损害其他发射指标”显得很宽泛,如果看主要影响,可以理解为:最大发射功率下不损害发射机线性度,最小发射功率下保持输出信号信噪比。

最大发射功率下,发射机输出往往逼近各级有源器件(尤其末级放大器)的非线性区,由此经常发生的非线性表现有频谱泄漏和再生(ACLR/ACPR/SEM),调制误差(Phase Error/EVM)。此时最遭殃的基本上都是发射机线性度,这一部分应该比较好理解。

最小发射功率下,发射机输出的有用信号则是逼近发射机噪声底,甚至有被“淹没”在发射机噪声中的危险。此时需要保障的是输出信号的信噪比(SNR),换句话说就是在最小发射功率下的发射机噪声底越低越好。

在实验室曾经发生过一件事情:有工程师在测试ACLR的时候,发现功率降低ACLR反而更差(正常理解是ACLR应该随着输出功率降低而改善),当时第一反应是仪表出问题了,但是换一台仪表测试结果依然如此。我们给出的指导意见是测试低输出功率下的EVM,发现EVM性能很差;我们判断可能是RF链路入口处的噪声底就很高,对应的SNR显然很差,ACLR的主要成分已经不是放大器的频谱再生、而是通过放大器链路被放大的基带噪声。

接收机动态范围

接收机动态范围其实与之前我们讲过的两个指标有关,第一个是参考灵敏度,第二个是接收机IIP3(在讲干扰指标的时候多次提到)。

参考灵敏度实际上表征的就是接收机能够识别的最小信号强度,这里不再赘述。我们主要谈一下接收机的最大接收电平。

最大接收电平是指接收机在不发生失真情况下能够接收的最大信号。这种失真可能发生在接收机的任何一级,从前级LNA到接收机ADC。对于前级LNA,我们唯一可做的就是尽量提高IIP3,使其可以承受更高的输入功率;对于后面逐级器件,接收机则采用了AGC(自动增益控制)来确保有用信号落在器件的输入动态范围之内。简单的说就是有一个负反馈环路:检测接收信号强度(过低/过高)-调整放大器增益(调高/调低)-放大器输出信号确保落在下一级器件的输入动态范围之内。

这里我们讲一个例外:多数手机接收机的前级LNA本身就带有AGC功能,如果你仔细研究它们的datasheet,会发现前级LNA会提供几个可变增益段,每个增益段有其对应的噪声系数,一般来讲增益越高、噪声系数越低。这是一种简化的设计,其设计思想在于:接收机RF链路的目标是将输入到接收机ADC的有用信号保持在动态范围之内,且保持SNR高于解调门限(并不苛求SNR越高越好,而是“够用就行”,这是一种很聪明的做法)。因此当输入信号很大时,前级LNA降低增益、损失NF、同时提高IIP3;当输入信号小时,前级LNA提高增益、减小NF、同时降低IIP3。

温度补偿

一般来讲,我们只在发射机作温度补偿。

当然,接收机性能也是受到温度影响的:高温下接收机链路增益降低,NF增高;低温下接收机链路增益提高,NF降低。但是由于接收机的小信号特性,无论增益还是NF的影响都在系统冗余范围之内。

对于发射机温度补偿,也可以细分为两部分:一部分是对发射信号功率准确度的补偿,另一部分是对发射机增益随温度变化进行补偿。

现代通信系统发射机一般都进行闭环功控(除了略为“古老”的GSM系统和Bluetooth系统),因此经过生产程序校准的发射机,其功率准确度事实上取决于功控环路的准确度。一般来讲功控环路是小信号环路,且温度稳定性很高,所以对其进行温度补偿的需求并不高,除非功控环路上有温度敏感器件(譬如放大器)。

对发射机增益进行温度补偿则更加常见。这种温度补偿常见的有两种目的:一种是“看得见的”,通常对没有闭环功控的系统(如前述GSM和Bluetooth),这类系统通常对输出功率精确度要求不高,所以系统可以应用温度补偿曲线(函数)来使RF链路增益保持在一个区间之内,这样当基带IQ功率固定而温度发生变化时,系统输出的RF功率也能保持在一定范围之内;另一种是“看不见的”,通常是在有闭环功控的系统中,虽然天线口的RF输出功率是由闭环功控精确控制的,但是我们需要保持DAC输出信号在一定范围内(最常见的例子是基站发射系统数字预失真(DPD)的需要),那么我们就需要将整个RF链路的增益比较精确的控制在某个值左右——温补的目的就在于此。

发射机温补的手段一般有可变衰减器或者可变放大器:早期精度稍低以及低成本精度要求较低的情况下,温补衰减器比较常见;对精度要求更高的情形下,解决方案一般是:温度传感器+数控衰减器/放大器+生产校准。

发射机功率控制

讲完动态范围和温度补偿,我们来讲一个相关的、而且非常重要的概念:功率控制。

发射机功控是大多数通信系统中必需的功能,在3GPP中常见的诸如ILPC、OLPC、CLPC,在RF设计中都是必需被测试、经常出问题、原因很复杂的。我们首先来讲发射机功控的意义。

所有的发射机功控目的都包含两点:功耗控制和干扰抑制。

我们首先说功耗控制:在移动通信中,鉴于两端距离变化以及干扰电平高低不同,对发射机而言,只需要保持“足够让对方接收机准确解调”的信号强度即可;过低则通信质量受损,过高则空耗功率毫无意义。对于手机这样以电池供电的终端更是如此,每一毫安电流都需锱铢必量。

干扰抑制则是更加高级的需求。在CDMA类系统中,由于不同用户共享同一载频(而以正交用户码得以区分),因此在到达接收机的信号中,任何一个用户的信号对于其他用户而言,都是覆盖在同一频率上的干扰,若各个用户信号功率有高有高低,那么高功率用户就会淹没掉低功率用户的信号;因此CDMA系统采取功率控制的方式,对于到达接收机的不同用户的功率(我们称之为空中接口功率,简称空口功率),发出功控指令给每个终端,最终使得每个用户的空口功率一样。这种功控有两个特点:第一是功控精度非常高(干扰容限很低),第二是功控周期非常短(信道变化可能很快)。

在LTE系统中,上行功控也有干扰抑制的作用。因为LTE上行是SC-FDMA,多用户也是共享载频,彼此间也互为干扰,所以空口功率一致同样也是必需的。

GSM系统也是有功控的,GSM中我们用“功率等级”来表征功控步长,每个等级1dB,可见GSM功率控制是相对粗糙的。

*干扰受限系统

这里提一个相关的概念:干扰受限系统。CDMA系统是一个典型的干扰受限系统。从理论上讲,如果每个用户码都完全正交、可以通过交织、解交织完全区分开来,那么实际上CDMA系统的容量可以是无限的,因为它完全可以在有限的频率资源上用一层层扩展的用户码区分无穷多的用户。但是实际上由于用户码不可能完全正交,因此在多用户信号解调时不可避免的引入噪声,用户越多噪声越高,直到噪声超过解调门限。

换而言之,CDMA系统的容量受限于干扰(噪声)。

GSM系统不是一个干扰受限系统,它是一个时域和频域受限的系统,它的容量受限于频率(200kHz一个载频)和时域资源(每个载频上可共享8个TDMA用户)。所以GSM系统的功控要求不高(步长较粗糙,周期较长)。

发射机功率控制与发射机RF指标

讲完发射机功控,我们进而讨论一下在RF设计中可能影响发射机功控的因素(相信很多同行都遇到过闭环功控测试不过的郁闷场景)。

对于RF而言,如果功率检测(反馈)环路设计无误,那么我们对发射机闭环功控能做的事情并不多(绝大多数工作都是由物理层协议算法完成的),最主要的就是发射机带内平坦度。

因为发射机校准事实上只会在有限的几个频点上进行,尤其在生产测试中,做的频点越少越好。但是实际工作场景中,发射机是完全可能在频段内任一载波工作的。在典型的生产校准中,我们会对发射机的高中低频点进行校准,意味着高中低频点的发射功率是准确的,所以闭环功控在进行过校准的频点上也是无误的。然而,如果发射机发射功率在整个频段内不平坦,某些频点的发射功率与校准频点偏差较大,因此以校准频点为参考的闭环功控在这些频点上也会发生较大误差乃至出错。

结语:到这一篇为止,“常见通信RF指标的内在和意义”系列将告一段落。事实上通信相关的RF指标还有很多(不相信的话去看看3GPP的测试规范就知道,R&S一套8950卖那么贵不是没有道理的),我们只是粗略的摘取了一些我们在现有RF工程中经常遇到的。后续如果有读者希望讨论更多的通信RF指标,可以与我们联系,大家共同探讨进步。谢谢!

天线纯干货系列(一)–从锤子T2的“无断点”说起

——80年代人,射频攻城狮,闲时爱好码字儿,喜欢即兴发挥,也擅命题作文。现为FindRF特约专栏作者,自己也经营着一个低产微信公众号“猪头是头猪”(没错,正着念倒着念是一样的),公众号ID:Huey-Dewey-Louie(没错,就是唐老鸭的那三个侄子)。

猪头之前写的都是“情怀”类文章(不是某人特别喜欢讲“情怀”么,猪头亦不能免俗),写多了未免空洞无物,于是今天来一篇干货。

某Chui最近发布了一款叫T2的手机,其中提到了一个被称为“解决了手机工程上的著名难题”的全金属中框。

之后很多评测出来了,为了“金属中框到底是不是天线”讨论了半天,众说纷纭。如果看了网上的拆解图,内行工程师应该可以马上判断出来——说句得罪人的话:不管哪一行,瞎咋呼的都是外行。

那么结论是什么呢?

结论是:T2的金属中框确实是用作天线辐射体。判断理由是什么呢?这里我们先说个非专业人士也能看懂的原理:找天线,先找RF-Ant Interface(射频-天线接口)。这种接口最明显的特征有两个:测试点(特征:射频连接器)和天线触点(特征:连接弹(tan第二声)片)。一般来说有几个射频连接器就应该有几路射频信号;有几个天线触点就有几个天线馈点(注意各种扬声器、麦克风等等器件也常用弹片与PCB相连,需要与天线区分)。

因为显然我是没有真机的,所以就看网上的拆解图来分析(本文图片均采自网络):

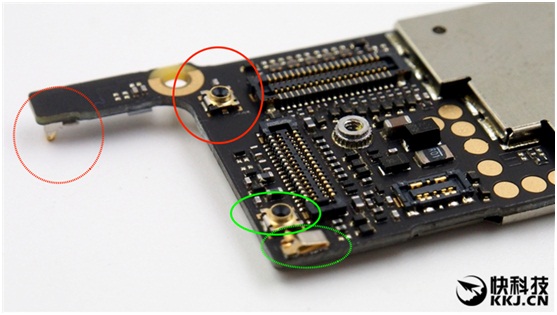

01 先看底端天线

图一是T2主板PCB底端,可以看到正面有两个射频连接器(红绿色实线圈),正反面各有一个弹片(红绿色虚线圈),所以这里应该有两路射频信号。按照射频工程实现,这两路应该是通过双工器按照频率分开的,典型的我们会把蜂窝制式中低频(1GHz以下)、中频(1GHz~2.2GHz)、高频(2.3GHz以上)信号作这样的分路处理,至于如何组合就各有千秋了。所以这里应该是有两路不同频率范围的信号,红色射频连接器与红色弹片相连,绿色射频连接器与绿色弹片相连。两个实线框内的射频连接器都是我们称之为“switchconnector”的类型,即在不插入测试探针情况下为直通(射频信号直达相对应的弹片),而一旦插入测试探针,射频信号则与弹片断开而通向探针以供测试。

图一

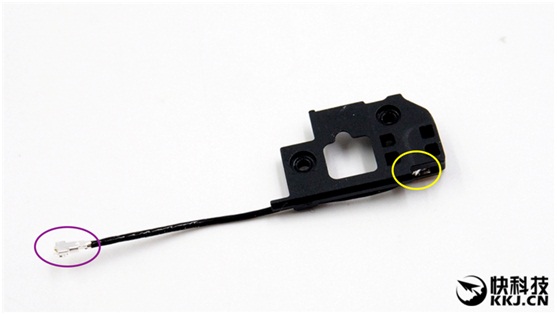

图二延续上一个话题,是T2底端的扬声器组件,背面有一段FPC(黄色实线框),FPC的一端接上一张图中绿色虚线所指弹片,另一端用螺丝与金属中框相连(蓝色实线框位置),作为一个天线馈点存在。

图二

也许有人会问,这个FPC不可以是天线么?我得说,按照这种形状做出来的FPC,可以是天线,但是绝对不是一个能用的多模多频段手机天线。天线需求的那么多谐振如果用这种两折就给折出来了,那大概是天顶星技术。

当然,以扬声器模块这样的面积,有没有可能做出可用的FPC天线,那是另一个话题,我们下篇再讨论。

图三是金属中框的概览,蓝色虚线框内的触点应该是与第一张图中红色虚线所指弹片相连的,这也是一个天线馈点。

图三

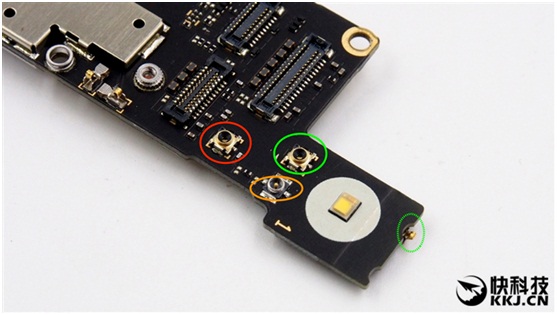

02再看顶端天线

图四是主板PCB顶端,这里有两个switchconnector(红绿实线圈),但是只有一个弹片(绿色虚线圈),另外有一个射频同轴电缆连接器(橙色实线圈)。按照走线方向看,绿色switch connector应该是与绿色弹片相连,红色switch connector应该是与射频同轴电缆连接起相连。这里也是有两路分开的射频信号。从弹片的方向,可以判断弹片应该是与中框的内壁相接触,此为天线馈点之一。

图四

下面我们看看另一路信号从同轴电缆连接器开始的路径:如图五所示,同轴射频电缆一端(紫色实线圈)与上图中橙色实线圈所示连接器相连,另一端(黄色实线圈)与小板上的射频同轴连接器相连。

图五

图六是小板翻过来看到的,红色虚线圈所指的弹片就是射频信号输出点,也是与中框内壁相接触,作为另一个天线馈点。

图六

03 天线是如何分配的?

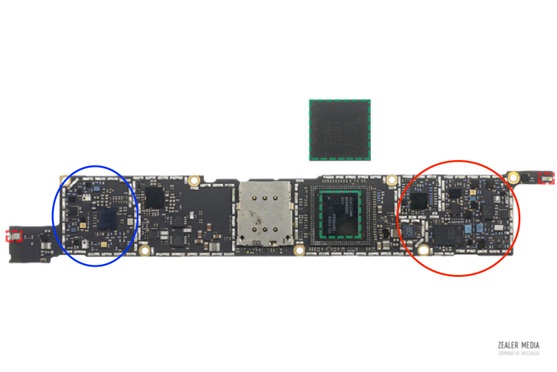

天线的分配,很大程度上取决于PCB上射频电路的位置——就近不求远,这是个大原则,因为每一段走线,无论是PCB上的微带线、带状线,还是更贵的同轴射频电缆,都会引入插入损耗:对于下行链路来说,从天线到接收机,每0.1dB的插入损耗就意味着接收灵敏度0.1dB的恶化;对上行链路而言,每0.1dB的插入损耗就意味着需要提高0.1dB的输出功率、以及由此带来的信号线性度和功耗的压力。那么我们来看看T2的射频电路在哪里。网上比较难找到清晰的图,不过这张够用了(图七),红圈里是蜂窝射频部分,蓝圈部分稍后讨论。至于说为什么判断红圈里是蜂窝部分,我只能说射频器件外形和走线规则是跟其他电路不同的,红圈里除了收发信模块,其余的一看就是一堆PA、开关和无源器件。

那么我们可以判断,蜂窝天线馈点应该在底端,尽量靠近射频电路,也就是底端的两个或者其中的一个。

图七

我这里用一张T2的开箱图(图八),可以看到盒子上标明的频段支持。主流频段基本上都是支持的。

图八

一般来讲,我们会倾向于将蜂窝制式中的高中低频段拆成两组,高中频段/低频段或者高频段/中低频段,分别馈入两个不同的天线。原因有二:一是满足高/中/低频段的三工器插入损耗太大成本也太高,二是如果用单馈天线,做出满足所有高中低频段谐振的手机天线难度太大。

所以我判断,T2底端的两个天线馈点,应该是提供给分成两组的蜂窝通信信号。

04 顶端的天线馈点是如何分布的?

T2支持WLAN/BT/GPS,一般我们会做一个单独的天线给它用。一方面它们都是非蜂窝制式(不用来打电话),二则多数(至少中国的CTA)认证测试对它们的OTA(Over-the-air)性能没有要求或者要求甚低(GPS会有A-PGS的测试);换句话说,就是“性能烂就烂点没关系,反正能敲个紫色的‘合格’章”。另一方面我们还需要一个蜂窝制式的接收分集天线(这在LTE中是必须的),但是这个天线性能也是“烂点就烂点没关系”的状态,因为现在至少CTA认证中基本上是测主集(就是主天线,如T2底端的天线)的OTA性能。话说回来,并不是每家都照着“烂点就烂点”的态度去做的,一来地球上有很多运营商对手机OTA有非常严格的要求,二来技术水平高的工程团队能做出来的东西不是小作坊能比的。

回到T2顶端的天线问题上来,刚才我说到过PCB上蓝圈里的电路,因为照片实在看不清楚,我只能猜测这一块可能与WLAN/BT/GPS有关,因为我看到了几个貌似滤波器的东西。

综上所述

综上所述,我推测顶端的两个天线馈点一个是给蜂窝制式的分集接收,另一个是给WLAN/BT/GPS。虽然说分集天线的馈点看上去距离蜂窝制式射频电路距离很远,如前所述这意味着链路上更大的插入损耗——但是不要忘了分集接收性能“烂就烂点”的“大原则”,所以把分集天线摆在顶端也是可以接受的。这样我们就理清了T2的天线分布:两个蜂窝制式(主集)天线馈点在底端,一个蜂窝制式(分集接收)天线馈点和一个WLAN/BT/GPS天线馈点在顶端。

天线干货(二) – 金属外壳天线的前世今生

射频君

上一篇里我们分析了锤子T2的“金属中框天线”的构成,在讨论其“创新”无断点设计之前,我们先来回顾一下金属外壳天线的前世今生。

为了不必要的麻烦,本文所有图片和内容均来自网络。

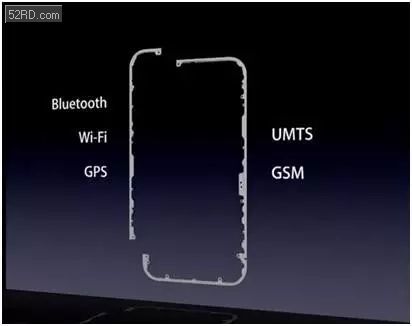

说到金属外壳天线,我们首先想到的一定是iPhone4。

对于这只手机,我只能说,帮主这样的天才,五十年才出一个。

当然,这支手机也爆出过“天线门”,就是因为它这个独树一帜的金属边框天线。

在那个年代,这种设计是非常大胆的,因为当时绝大部分手机还在老老实实的用FPC天线,就像这样:

so,问题来了

做成这种曲曲折折拐弯抹角是干啥?

这里牵涉到天线设计上三个概念:电长度,谐振和效率。

电长度

所谓电长度,形象的说就是“天线的导体长度,与某个特定频率信号波长的比值”。在传统的偶极子/单极子天线中,天线要能有效的将信号辐射出去,电长度需要至少达到信号波长的四分之一(单极子天线)。当然这样对手机天线是不现实的——对于700MHz左右的频率,波长40cm,四分之一波长也需要10cm。在做电长度分析的时候,天线的馈电点和接地点是电流腹点(振幅最大),而开路点是电流节点(振幅最小);两腹点之间/节点之间的距离,是半波长的整数倍,腹点和节点之间的距离,是四分之一波长的整数倍——请记住这个结论,后面分析的时候用得到。

谐振

谐振,按照我们工程师最直观的标准,就是当自由空间天线接在网络分析仪端口上的时候,回波损耗(RL)足够低。用通俗易懂的说法,就是此时天线与自由空间组成了一个在特定频率上谐振的电路,能够容纳这个频率的信号通过(实际上就是辐射到自由空间中去了)。

效率

效率,这是最值得关心的。在天线辐射的过程中,有多少功率是真正发射到辐射场中去了,又有多少功率是损耗在辐射体上(导体损耗、介质损耗等等)——前者才是我们需要的部分,而我们优化天线设计的目的也是不断的增加前者的比例。

很多年前我在毕业论文里做天线设计的时候,还总是抓住电长度和电流程的概念不放。事实上在手机天线设计里,很多概念是不适用的,譬如我们学生做天线总是要先假设一个“无限大理想平面”作为地平面,但是手机PCB的尺寸已经与信号波长相仿,显然不可以再用它作为地平面来分析——手机PCB不是地平面,而是辐射体的一部分。

当然足够尺寸的“纯净”天线辐射体永远是必须的,否则无法拥有足够的辐射效率;而所谓“纯净”的天线辐射体,就需要净空(clearance),即三个维度都必须与金属(包括PCB地)保持一定距离。为了这个净空,绝大多数手机都有个相对而言比较大的下巴——反正要摆实体/虚拟按键,再多给点提供出净空也不是大问题。

上面这张图是华为P8 Lite,下面四个红点附近的印在塑料部分上灰色的金属就是天线,这是激光印刻的,比当年的FPC又进化了一步,虽然原理是一样的。

第四代之前的iPhone也是用类似的设计,直到iPhone 4横空出世。从此全世界开始了一波“天下文章一统抄”的金属机身天线潮流。

发现没有,它们的金属边框天线都有断点。

公孙玉龙说它家的T2“没有断点”,“工匠精神”哦!

第一个问题

没有断点的金属边框天线是不是可行的?

从设计原理看,断点就是电流节点,接地点就是电流腹点,如果要提供足够的电长度实现谐振,我们完全可以在金属边框适当的地方作接地处理,所以它确实是可行的!

我相信T2的金属边框应该在特定的地方设计了多个接地点。具体设计我不敢妄言,但是肯定可行,而且消除了白边断点,从外观上也是利好。

第二个问题

为什么那么多金属边框天线手机,都要作断点设计?

为了将手持的影响最小化!

为了将手持的影响最小化!

为了将手持的影响最小化!

重要的事情说三遍。

手持的影响到底能有多大呢?先看看我们中国的OTA认证标准(CTA)里的要求:“手持情况下比自由空间TIS最多恶化8dB。”(TIS:total-isotropic-sensitivity,全向灵敏度。)这已经是很放松的标准,而事实上这个标准也并没有得到很好的执行。

从某种意义上讲,金属边框天线的进化过程,就是与“手持影响”作斗争的过程。

这些“天线门”事件发生的本质都一样:手持状态下,手掌皮肤将断点两侧的金属(天线/天线,或者天线/接地)连接起来了,引起辐射效率明显下降。

在传统的FPC天线(内置)上,手持的影响主要是手部皮肤与天线辐射体的耦合作用(还记得“净空”的概念么?手握的效果类似于破坏了天线外方的“净空”),引起天线效率下降。但是到了金属外框天线的场景下,就是“赤裸裸”的接触式影响了,而且是接入了另一段金属(无论是辐射体还是接地),天线的有效电长度变化,天线性能的剧烈退化也就可以理解了。

但是金属边框天线有它无可替代的优势:美观(逼格暴涨,当然不要用那种国产机闪亮亮的材质,那是乡土气息),无需净空(改善下巴)。其实作为工程师而言,后者更重要——在如今PCB面积被反复挤压(都让给电池和各种花花绿绿的奇技淫巧了)的状况下,少一些净空就意味着可以多一点布板空间。

于是工程师们开始开发各种武功秘籍来对抗“手持影响”。

如果上面说的是真的,那么这确实是个非常聪明的做法,而且是从用户分析出发的——极少会有手同时抓握手机底部和顶部两侧的机会。代价是需要更加智能的算法支持,而且射频的设计必然更加复杂——不过,我们工程师的价值不就正在于此么?

应该说天线切换的概念并不新鲜。我在诺记时就有这样的设计原型,当时有两种天线切换策略:一种是用纯射频的方式实现——直接检测VSWR,以天线的回波损耗判断所受影响并决定如何切换;另一种是以RSSI的监测和比较,以判断哪个天线性能更佳。从工程实现看,后者是更好的,不仅仅是更易于实现(软件实现功能总之是比硬件实现划算的),而且我们事实上就遭遇过手握时VSWR明显改善但是天线效率下降的例子。

如果说金属边框天线是外化的天山折梅手,那么天线智能切换就是内在的小无相功,外在招式得到内力催动,便可成就上乘武功。

你也不得不佩服苹果的技术能力,这家做电脑出身的公司,愣是把无线黑科技一个又一个的推向市场而且大卖。

第三个问题

为什么我们不用两侧的金属边框作天线?

答案是并非全部不可以。事实上手机靠近顶端两侧的部分经常有天线分布,无论内置(金属片、FPC)或者外置(金属边框部分),当然前提是要尽量避开按键(音量、开关机)和卡槽(SIM、TF),因为它们必然有金属和接地。

而且我们同时要尽量避免辐射体被手直接握持接触,这种握持经常是能让信号条嗖嗖往下掉的。

其实更致命的还是净空需求:我们可以容忍手机顶端的大脑门(反正要放前摄像头和听筒)和底端的大下巴(横竖有扬声器和USB、按键),但是能容忍两侧7mm白边么?要知道屏幕总成两边都是亮晶晶的金属,天线的天敌。。。

第四个问题

锤子T2的全金属中框天线算什么?

回答:我推测它是一种忽视用户体验的装逼行为。

作为攻城狮,no datanobb,我没有它的OTA数据,只能说我是推测,但是我可以说说我推测的理由。

首先是高频性能,3GPP的高频段包括B7/38/40/41,带宽一个比一个宽,B41已经达到丧心病狂的196MHz。一般来讲高频性能的瓶颈并不是频率(对射频电路而言是,但是对天线反而不是),而是带宽。

T2的金属中框是整个连起来的,没有断点,而且有多处接地,但是这样的缺点是寄生参数太多,调谐高频的宽频谐振很难。但是过认证是有办法的,因为在泰尔实验室过认证只测试CTA需求的频段,按照T2的包装上写的明明白白的“B41支持中国移动频段”,就是说B41只用满足2575MHz~2635MHz,过认证能上市卖就好。有评测说它B38性能不错,这不奇怪,B38是2570MHz~2620MHz,更窄,只偏了5MHz而已。至于B41频段的其它部分,譬如分给联通和电信的部分,我很怀疑它的性能;遑论去美国的时候漫游到sprint的坑里,人家要求的可是B41全频段。

然后是手持影响,前面说过金属边框天线最怕就是手持,主流厂商掉坑里的不止一个两个,所以才有了天线智能切换技术。但是T2没有断点,手一旦抓上去那就是玉石俱焚。有断点的设计则不同,譬如单手握持情况下至少有一处天线不会被直接接触,前面所说的天线切换就大有可为了。

网上有个测试报告说T2在双手模型测试下MIMO OTA性能如何好,我很奇怪为什么不测单手的状况?单手握持的手模,与金属边框接触是最多的,甚至于某些点接触还是不接触都会影响巨甚。难道HL、HR或者HHL、HHR(分别是:左手持、左手持、左手持左耳听、右手持右耳听)这些最典型的测试用例反而被忽略掉了?

最后一个问题

T2的天线设计是不是最优的?

这个“最优”太难定义,但是我可以说的是,在它现有的设计基础上,这个解决方案不是最优的。

这里分两部分来说:

第一,整体硬件设计是不怎么样的。

看看这个PCB,器件的密度很差,射频部分走线应该是比较乱的。真要是有“工匠精神”的话,这些都应该拆了重画。现在这种设计实在浪费了太多空间。如果要跟其它国产手机比比,那不妨看看华为的设计,差距甚大。

第二,如果看底端主天线周围的空间,用FPC或者激光雕刻做出天线来并不是不可能的。

这块部分诚然有扬声器等器件,但是大部分手机也都是把扬声器等器件放在这里的,然后在同一片地方做出性能优良的FPC天线并不是罕见的事情,譬如华为P8 Lite:

T2的B-cover不是金属的,做这样的FPC天线应该不是难事,但是它没这么做,至于是情怀还是能力我不知道,不作评论。

总结

我写下这些东西,是在我已经失去了实验室资源,全靠经验来分析的情况下完成的,困难重重。以前有全套实验室的时候,我经常申请买来竞争对手的手机,拆了来测试,测完之后常常很鄙视的“哼,做这么烂还好意思拿出来卖”——当然只能眼睁睁看着它们继续大卖。

这个世界是利益纠缠的,卖手机的,卖设计服务的,卖测试服务的,卖评测的,全在一个“卖”字;我经常会看着那些个冠冕堂皇的评测或者分析发笑——要不是IQ不够,要不就是良心没有,或者两者都占全了。

所以我这么个只喜欢写东西喷人的工程师依旧穷的叮当响,卖这个的卖那个的依旧赚的盆满钵满。

这就是这个世界的真相——说真话不赚钱。